ChatGPT蜜月期结束了吗?

ChatGPT自去年发布以来风靡全球。然而,最近的一项调查发现,75% 的企业已经实施或正在考虑在其工作场所禁止 ChatGPT 和其他生成式 AI 应用程序。

为什么公司对 ChatGPT 感到冷淡?

这并不是说他们怀疑它的能力。相反,他们担心潜在的网络安全风险。

日益关注的问题:数据泄露和 ChatGPT

生成式 AI 工具旨在从每次交互中学习。您提供给它们的数据越多,它们就会变得越聪明。听起来不错,对吧?

但是,关于数据的去向、谁可以看到数据以及如何使用数据,存在一个灰色地带。

这些隐私问题导致意大利数据保护机构在 4 月暂时禁止 ChatGPT。

对于企业来说,担心的是 ChatGPT 可能会获取用户提交的信息,从中学习,并可能让它在未来与其他用户的互动中溜走。

OpenAI 的 ChatGPT 指南表明,可以审查用户数据并用于完善系统。但这对数据隐私意味着什么?

答案并不明确,这就是导致焦虑的原因。

数据泄露担忧:真正的风险是什么?

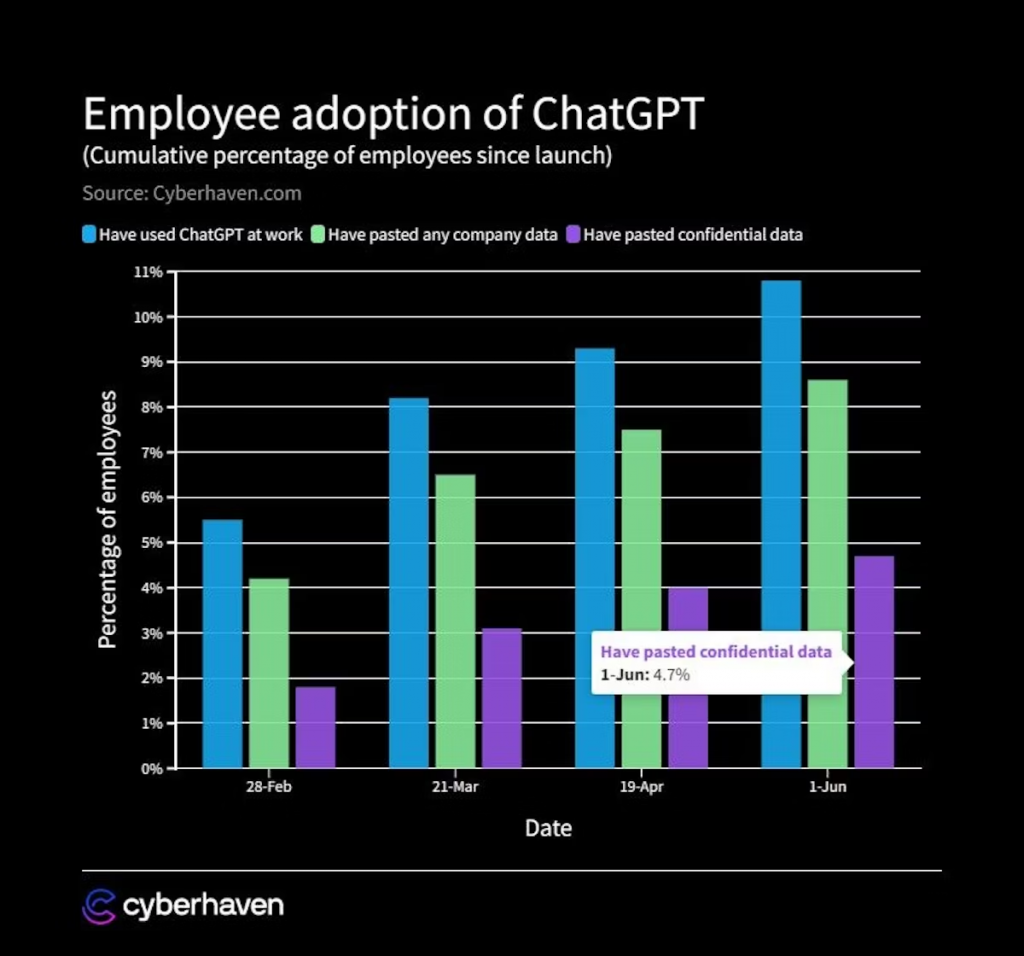

Cyberhaven 的一项研究发现,截至 1 月 10 日,8.8% 的员工在工作中使用 ChatGPT,其中 6.4% 的人输入公司信息。令人震惊的统计数据是,7.<>%的工人在ChatGPT中输入了机密信息。

而且由于 ChatGPT 的工作方式,缺乏传统的安全措施。大多数安全产品旨在保护文件不被共享或上传。但 ChatGPT 用户将内容复制并粘贴到他们的浏览器中。

现在,OpenAI 增加了一个退出选项。用户可以请求他们的数据不用于进一步的培训。

但选择退出不是默认设置。因此,除非用户意识到并采取积极措施,否则他们的交互可能会被用来训练人工智能。

担忧并不止于此。

即使您选择退出,您的数据仍会通过系统。虽然 OpenAI 向用户保证数据得到负责任的管理,但 ChatGPT 就像一个黑匣子。目前尚不清楚数据在引入后如何在系统内流动。

还有出错的风险。

21 年 2023 月 <> 日,OpenAI 关闭了 ChatGPT,因为一个故障错误地将聊天记录命名为不同用户的名字。如果这些标题包含私人或敏感细节,其他 ChatGPT 用户可能已经看到了它们。该漏洞还暴露了一些 ChatGPT Plus 订阅者的个人数据。

三星事件

第一次重大的ChatGPT数据泄露发生在今年早些时候,涉及科技巨头三星。据彭博社报道,敏感的内部源代码在工程师上传到 ChatGPT 后被意外泄露。

像这样的泄漏可能会产生严重的影响。

而且不仅仅是三星。亚马逊是科技行业的另一家巨头,也有自己的担忧。该公司发现 ChatGPT 的响应与亚马逊的内部数据惊人地相似。

如果 ChatGPT 拥有亚马逊的专有数据,那么是什么阻止了它无意中将其泄露给竞争对手?

缺乏明确的法规

生成式人工智能工具的快速发展和采用使监管机构迎头赶上。关于负责任使用的准则有限。

那么,如果由于人工智能而发生数据泄露,谁来负责——使用该工具的公司、员工还是人工智能提供商?

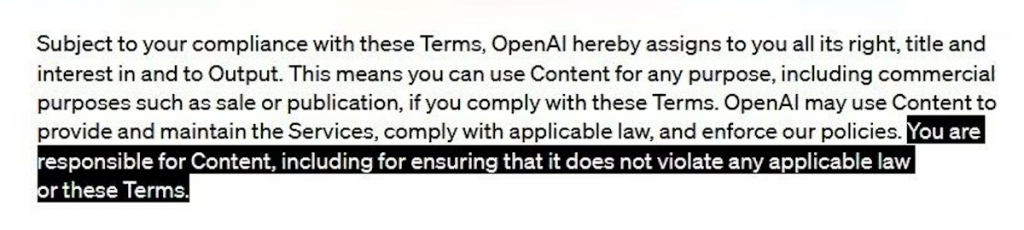

在 OpenAI 的使用条款中,责任在于用户:

这给公司带来了风险。如果没有明确的规定,他们只能决定最佳行动方案。这就是为什么许多人现在变得更加犹豫不决的原因。

技术领导者的矛盾观点

在部署新技术时,企业通常会寻求技术领导者的帮助。如果一家科技巨头采用一项新的创新,它通常被视为其他公司效仿的绿灯。

因此,当一家像Microsoft这样有影响力的公司对一项技术发出混合信号时,整个行业都会感受到涟漪。

一方面,Microsoft对生成式人工智能工具的使用持保留态度。今年1月,Microsoft警告员工不要与ChatGPT分享“敏感数据”。

但Microsoft也支持自己的技术版本,即 Azure ChatGPT。此迭代承诺为企业用户提供更安全、更可控的环境。

此举引发了问题:Azure ChatGPT 是否真的不受Microsoft在更广泛的生成式 AI 领域中指出的风险的影响?或者,这是确保企业留在Microsoft生态系统中的战略策略?

采用ChatGPT的平衡

在评估任何新技术时,企业经常陷入潜在收益和潜在陷阱之间的拉锯战。

对于ChatGPT,公司似乎正在采取观望态度。

随着技术及其法规的发展,希望能够建立更安全、更透明的使用。